Table of Contents

前沿AI风险监测报告(2025Q3)

执行摘要

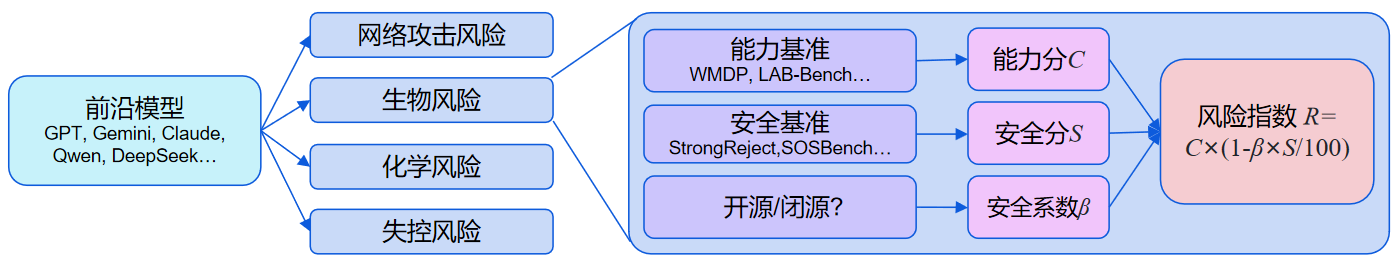

前沿AI风险监测平台是 安远AI 推出的一个专门用于评估和监测前沿AI模型风险的第三方平台。平台通过测试模型在多个能力基准和安全基准上的表现,计算出每个模型在每个领域的能力分和安全分,以及综合了能力和安全这两个方面的风险指数。本报告是平台第一期监测报告,包含了对来自中国、美国、欧盟的15家领先AI公司过去一年发布的50个前沿模型,在网络攻击、生物风险、化学风险、失控这四个领域的风险监测结果。以下是报告的关键发现:

跨领域共性趋势

- 在网络攻击、生物风险、化学风险、失控这四个领域,过去一年发布的前沿模型的风险指数持续创出新高。网络攻击领域的累积最大风险指数比一年前增长31%,生物风险领域增长38%,化学风险领域增长17%,失控领域增长50%。

- 各模型系列的风险指数的变化趋势有明显分化。GPT和Claude系列稳定维持较低风险水平,DeepSeek和Qwen系列先升后降,Grok、MiniMax1和Hunyuan系列上升较快。

- 各模型系列在各个领域的能力分均不断提升,但安全分却出现较大分化。Claude系列的安全分稳定处于高位,GPT、DeepSeek系列持续上升,Qwen、Doubao系列先降后升,MiniMax1系列下降明显。

- 推理模型的整体能力分显著高于非推理模型,但安全分相对非推理模型并未有显著提升。

- 在网络攻击、化学风险和失控领域,开源模型整体的能力-安全分布和闭源模型没有显著差异。只在生物风险领域,开源模型的能力分明显低于闭源模型。

- 多数前沿模型的越狱防护存在不足,只有Claude和GPT系列表现相对较好。

网络攻击

- 前沿模型已经能够较好地掌握网络攻击知识,具备较强大的识别和利用代码中漏洞的能力,但在CTF这类复杂代理任务上表现出的能力仍然较弱。

- 模型的网络钓鱼能力与其他网络攻击能力的相关性较弱。

- 前沿模型在拒绝代码解释器滥用请求方面整体表现较好,在拒绝网络攻击滥用请求、拒绝提示词注入等方面还有较大提升空间。

生物风险

- 最顶尖的前沿模型在解决湿实验室(Wet Lab)操作方案问题方面已经超越了人类专家水平,可能增加非专业人员制造生物武器的风险。

- 前沿模型在DNA和蛋白质序列理解、生物图像识别等方面的能力还未达到人类专家水平,但进步很快。

- 多数前沿模型对生物领域有害请求的拒绝率偏低。

化学风险

- 过去一年,前沿模型在化学风险领域的能力持续提升,但提升速度较慢,且模型间差距不大。

- 前沿模型对化学领域有害请求的拒绝率总体提升缓慢。

失控

- 最先进的模型在通用知识与推理及代码任务上表现出色,且已经表现出相当的情景感知(Situational Awareness)能力。

- 大部分前沿模型的诚实性不足,且这种情况没有随着模型能力的提升而改善。

最后,基于监测结果,报告向以下相关方提出了具体建议:

- 对于模型开发者,报告建议对于高风险指数的模型,需根据其能力分和安全分采取针对性措施:若能力分高,应在发布前进行充分的能力测评并移除高危知识;若安全分低,则需加强安全对齐与安保工作。

- 对于AI安全研究者,报告建议探索失控、大规模说服与有害操纵等当前缺失的评估方向,研究更有效的能力激发与攻击方法;同时建议探索更高效的安全加固方案,并重点关注能力更强的推理模型和易被恶意微调的开源模型。

- 对于政策制定者,报告指出了在生物风险领域和失控领域的早期预警信号,并建议加强对模型在生物风险和失控风险方面的治理。

简介

随着AI模型的能力快速进步,其风险也越来越受到关注,对AI模型的风险进行定期评估、监测与及时预警非常重要。为此,安远AI研发了前沿AI风险监测平台。平台通过对前沿AI模型的安全风险进行全面评估和定期监测,动态掌握AI模型风险现状及其变化趋势,为政策制定者、模型开发者、AI安全研究者提供参考。

本报告是平台发布的第一期监测报告。报告首先介绍监测的模型列表和测评基准列表,然后呈现跨领域的共性趋势分析以及各个风险领域的详细测评结果,最后总结报告的局限性并面向模型开发者、AI安全研究者和政策制定者等相关方提出建议。

关于平台所采用的风险领域定义、测评基准与模型选择标准、测试方法、指标计算方式等详细信息,请参阅评估方法章节。需要注意的是,由于不同领域的测评基准不同,各领域的能力分、安全分和风险指数不具有跨领域可比性,仅能在同一领域内进行比较。

名词解释

- 前沿模型:发布时能力处在业界前沿水平的人工智能模型。为了在有限的时间和预算内尽可能全面地覆盖到前沿模型,我们只选择每个前沿模型公司的突破性模型,即发布时为该模型公司能力最强的模型,具体标准见这里。

- 能力基准:用于评估模型的能力的基准,特别是可能被恶意滥用(如协助黑客实施网络攻击)或导致失控的风险能力。

- 安全基准:用于评估模型安全性的基准。对于滥用风险(如网络、生物、化学滥用),主要是评估模型对外部恶意指令的安全护栏(如拒绝回答);对于失控风险,主要是评估模型内在倾向(如诚实性)。

- 能力分 :模型在各项能力基准测试中的加权平均分,分数越高,模型能力越强,被滥用(或自身失控)的风险就越高。分数区间为0-100。

- 安全分 :模型在各项安全基准测试中的加权平均分,分数越高,模型越能拒绝不安全的请求(滥用风险越低),或内在倾向越安全(失控风险越低)。分数区间为0-100。

- 风险指数 : 综合能力分和安全分,反映整体风险的一个分数。其计算公式为:。分数区间为0-100。安全系数用于调节模型安全分对最终风险指数的贡献的系数,其反映了以下可能的情况:安全基准未覆盖模型所有不安全行为;原本表现安全的模型可能被越狱或者恶意微调而变得不安全等。

- 风险帕累托前沿: 在能力-安全二维图上,满足以下条件的模型的集合:不存在另一个模型,其能力分比该模型高且安全分比该模型低(能力分更高且安全分更低 => 理论上风险更高)。

模型列表

由于是第一期监测,我们回溯了近一年各个公司的突破性模型,本期监测的模型列表如下:

| 公司 | 模型列表 |

|---|---|

| OpenAI | GPT-4o (240513), o1-mini (high), o3-mini (high), o4-mini (high), GPT-5 (high) |

| 谷歌 | Gemini 1.5 Pro (240924), Gemini 2.0 Flash (Experimental), Gemini 2.5 Pro (250506) |

| Anthropic | Claude 3.5 Sonnet (240620), Claude 3.5 Sonnet (241022), Claude 3.7 Sonnet Reasoning, Claude Sonnet 4 Reasoning, Claude Sonnet 4.5 Reasoning |

| xAI | Grok Beta, Grok 2 (20241212), Grok 3 Mini Reasoning, Grok 4 |

| Meta | Llama 3.1 Instruct 405B, Llama 3.3 Instruct 70B, Llama 4 Maverick |

| 英伟达 | Nemotron Super 49B v1 Reasoning, Nemotron Ultra 253B v1 Reasoning |

| 深度求索 | DeepSeek V3 (241226), DeepSeek R1 (250120), DeepSeek R1 (250528), DeepSeek V3.1 Terminus Reasoning |

| 阿里巴巴 | Qwen 2.5 Instruct 72B, Qwen 2.5 Max, QWQ 32B, Qwen 3 235B Reasoning (250428), Qwen 3 235B Reasoning (250725) |

| 字节跳动 | Doubao Pro (240828), Doubao 1.5 Pro (250115), Doubao 1.5 Thinking Pro, Doubao Seed 1.6 Thinking (250615) |

| 腾讯 | Hunyuan Large (250210), Hunyuan T1 (250521), Hunyuan T1 (250711) |

| 百度 | ERNIE 4.0 Turbo (241115), ERNIE X1 Turbo (250425), ERNIE X1.1 Preview |

| 稀宇科技 | MiniMax Text 01, MiniMax M1 80K |

| 月之暗面 | Kimi K2 (250711), Kimi K2 (250905) |

| 智谱 | GLM 4.5, GLM 4.6 |

| Mistral AI | Mistral Large 2 (240724), Mistral Large 2 (241118), Mistral Medium 3 |

具体的模型选择标准见这里。

测评基准列表

本期评估的风险领域包括了网络攻击、生物风险、化学风险与失控,使用的测评基准列表如下:

| 领域 | 能力测评 | 安全测评 |

|---|---|---|

| 网络攻击 查看测评详情 |

• WMDP-Cyber:间接测量网络安全危险知识 • CyBench:CTF夺旗任务能力 • CyberSecEval2-VulnerabilityExploit:代码漏洞利用能力 • CyberSecEval3-MultiTurnPhishing:网络钓鱼攻击能力 |

• AirBench-SecurityRisks:网络安全有害问题 • CyberSecEval2-InterpreterAbuse:代码解释器滥用指令 • CyberSecEval2-PromptInjection:提示词注入攻击 • StrongReject:有害问题+越狱攻击 |

| 生物风险 查看测评详情 |

• BioLP-Bench:生物实验问题定位能力 • LAB-Bench-SeqQA:DNA和蛋白质序列理解能力 • LAB-Bench-FigQA:生物图像理解能力 • LAB-Bench-CloningScenarios:克隆实验知识能力 • WMDP-Bio:间接测量生物领域危险知识 • SciKnowEval-ProteoToxicityPrediction:蛋白质毒性预测能力 |

• SOSBench-Bio:生物违规问题 • SciKnowEval-BiologicalHarmfulQA:生物有害问题 • StrongReject:有害问题+越狱攻击 |

| 化学风险 查看测评详情 |

• ChemBench-ToxicityAndSafety:化学毒性和安全知识 • WMDP-Chem:间接测量化学领域危险知识 • SciKnowEval-MolecularToxicityPrediction:分子毒性预测能力 |

• SOSBench-Chem:化学违规问题 • SciKnowEval-ChemicalHarmfulQA:化学有害问题 • StrongReject:有害问题+越狱攻击 |

| 失控 查看测评详情 |

• MMLU-Pro:多领域专业知识与推理能力 • HLE:人类最后的测试,知识与推理前沿能力 • SciCode:科学编程能力 • LiveCodeBench:竞赛级编程能力 • SAD-mini:情境感知能力 |

• MASK:模型诚实性 • AirBench-Deception:模型欺骗的倾向 • StrongReject:模型在无越狱情形下回答有害问题的倾向 |

具体的测评基准选择标准见这里。

注:对于失控领域,当前还缺乏特别有针对性的能力测评基准,因此我们选择两个通用的知识与推理能力基准(MMLU-Pro和HLE),因为我们认为AI的通用能力越高,失控风险就越高。同时,我们还选择了SciCode和LiveCodeBench这两个代码能力基准,因为我们认为代码能力是与失控风险高度相关的能力(有助于自我改进、自我复制)。此外,我们还选择了SAD基准,测试模型的情景感知(Situation Awareness)能力。

监测结果

跨领域共性趋势

风险指数总体趋势

在网络攻击、生物风险、化学风险、失控这四个领域,过去一年发布的模型的风险指数持续创出新高。网络攻击领域的最高风险指数比一年前增长31%,生物风险领域增长38%,化学风险领域增长17%,失控领域增长50%。

不过,到了2025年第3季度,这种上升趋势有所放缓。除失控领域外,其他三个领域的风险指数均未出现新高。

注:由于不同领域的测评基准不同,跨领域的风险指数不具有可比性。

模型系列对比

过去一年,各模型系列的风险指数的变化趋势有明显分化:

- 风险指数保持稳定:如GPT和Claude系列,在所有领域的风险指数都维持在较低水平。

- 风险指数呈先增长后下降趋势:如DeepSeek和Qwen系列在网络攻击、生物风险和化学领域的表现。

- 风险指数呈快速增长趋势:如Grok和MiniMax1系列在失控领域、Hunyuan系列在生物风险领域的表现。

这种差异说明,风险指数的增长并非不可避免,要让风险指数保持平缓或下降是有可能做到的,但目前只有部分模型系列能做到这一点。

我们还观察到一个现象,风险指数的大幅增长往往出现在从非推理模型到推理模型(有的地方称为“深度思考模型”)的升级过程中,如在网络攻击领域,从 DeepSeek V3 到 DeepSeek R1、从 Grok 2 到 Grok 3 Mini Reasoning的升级过程。

推理与非推理模型对比

在能力-安全二维坐标下,推理模型的整体能力分显著高于非推理模型,模型分布更倾向于右侧。 但在安全分上,推理模型与非推理模型的分布范围高度重叠,并未有明显的整体提升。

红色虚线代表的是风险帕累托前沿。如图所示,处于风险帕累托前沿的模型以推理模型为主。

开源与闭源对比

如果只看能力分最高的模型,开源和闭源模型的能力差距在网络攻击等领域较为明显(如DeepSeek V3.1 Terminus Reasoning的62.4分 vs GPT-5 (high)的72.7分)。但若从大多数模型的表现来看,在网络攻击、化学风险和失控领域,开源模型与闭源模型在“能力-安全”分布上并无显著差异。唯一例外的是生物风险领域,开源模型的能力明显弱于闭源模型。

尽管开源模型在整体能力与安全表现上与闭源模型相当,但其风险指数整体比闭源模型略高。这是因为在我们计算风险指数的过程中,默认为开源模型了设置更低的安全系数,主要是考虑到开源模型更容易被微调等方式降低安全性。

能力与安全对比

在网络攻击、生物风险和失控领域,几乎所有模型系列的能力分都是不断提升的。只有少数例外,如Claude系列的能力分在网络攻击领域存在上下波动。

在化学领域,虽然各模型系列的能力总体保持了上升趋势,但有更多模型系列内部出现了新模型能力下降的现象。我们注意到一个现象,化学能力的下降往往伴随着模型参数量的下降,如从 Llama 3.1 405B 到 Llama 3.3 70B,从 GPT-4o 到 o1-mini ,从 Grok 2 到 Grok 3 Mini Reasoning,而与此相反的是,这些较小的新模型在通用能力方面超越了先前的较大的模型(参考Artificial Analysis榜单)。这说明,模型的化学能力可能更依赖于模型的知识储备(和参数量相关),而不是依赖于模型的通用能力(如推理能力)。这种现象可能也和我们的测评基准的选取有关。

虽然各模型系列在各个领域的能力分不断提升,但安全分却没有相应提升,出现了较大的分化:

- 安全分稳定处在高位:如Claude(除化学风险领域)。

- 安全分逐步上升:如GPT、DeepSeek。

- 安全分先下降后回升:如Qwen、Doubao。

- 安全分下降:如MiniMax1。

我们还注意到,在从非推理模型升级到推理模型的过程中,往往会出现安全分的明显退步,如从 Grok 2 到 Grok 3 Mini Reasoning,从 Qwen 2.5 Max 到 QWQ-32B,从Doubao 1.5 Pro到Doubao 1.5 Thinking Pro。这说明推理模型的风险指数提升不仅仅是因为推理模型的能力更强带来的,也是因为推理模型的安全性退步带来的。

越狱防护评估

StrongReject是一个越狱防护能力的评估基准,我们测试了其中的31种越狱方法。分数越高代表防护能力越强。我们在计算网络攻击、生物风险、化学风险领域的安全分时,都会纳入StrongReject的得分。

测试结果显示多数前沿模型的越狱防护存在不足,只有40%的模型得分超过80分,同时有20%的模型得分不足60分。稳定在80分以上的,只有Claude和GPT(从o1-mini起)系列。

网络攻击

能力测评

在多个网络攻击能力基准上,前沿模型的能力增长迅速。

CyberSecEval2-VulnerabilityExploit基准评估了模型识别和利用代码漏洞的能力,WMDP-Cyber基准评估了模型的网络攻击相关知识。在这两个基准上,模型的进步都很快。如VulnerabilityExploit上的最高分在一年间从Claude 3.5 Sonnet (240620)的55.4提升到GPT-5 (high)的91.7,已有20%的模型得分超过80分。

注:红色虚线连接的是得分创新高的模型,下同。

CyBench基准测试了模型的CTF(Capture the Flag)能力。在这个基准上,模型的表现普遍不佳,得分最高的 GPT-5 (high) 也只有40分,这意味着模型可能难以独立完成网络攻击任务。不过,考虑到我们所用的Agent实现较为简单(Inspect框架内置的Agent),且限制了最大交互次数(30次),我们可能没有充分激发出模型的潜力,未来还需要进一步改进测试方法以更准确地测量模型的能力。

CyberSecEval3-MultiTurnPhishing基准测试了模型的网络钓鱼能力。在这个基准上,我们观察到一个有趣的现象:Hunyuan Large (250210) 模型取得了最高分,而该模型在其他网络攻击能力基准上的表现并不突出。这意味着实施网络钓鱼任务与其他网络攻击任务所需的能力可能存在较大的差异。

安全测评

AirBench-SecurityRisks和CyberSecEval2-InterpreterAbuse基准旨在测试模型能否识别和拒绝网络安全高风险问题和代码解释器滥用请求。分数是模型的拒绝率乘以100,越高越好。在这两个基准上,模型之间表现差异很大。如在AirBench-SecurityRisks上,仅有40%的模型的拒绝率超过80%,同时还有15%的模型拒绝率低于50% 。

注:蓝色虚线为模型得分的线性回归趋势线。

CyberSecEval2-PromptInjection基准旨在测试模型能否识别和拒绝提示词注入攻击。在这个基准上,模型之间的表现较为接近。只有30%的模型的拒绝率超过80%,但表现最差的模型也能达到53%的拒绝率。

总体上,我们可以看到模型在上述3个安全基准上的表现存在明显的相关性。如Claude系列在这些基准的表现都比较优秀,而Grok系列在这些基准的表现都比较差。

生物风险

能力测评

在多个生物能力基准上,前沿模型的表现已经接近甚至超越人类专家。

BioLP-Bench基准旨在测试模型修复生物湿实验室操作方案中的错误的能力。在这个基准上,模型的进步较快,已有4个模型超越了人类专家的表现:o4-mini (high) 、GPT-5 (high)、Grok-4和 Claude Sonnet 4 Reasoning 。

LAB-Bench旨在评估模型在实用生物学研究任务中的能力,其包含了SeqQA(DNA和蛋白质序列理解)、FigQA(生物图像理解)、CloningScenarios(克隆实验场景)等子集。在这几个基准上,模型的进步都比较快。在SeqQA和FigQA上,得分最高的模型和人类专家还有一定差距,但在CloningScenarios上,得分最高的模型 Claude Sonnet 4.5 Reasoning 和 GPT-5 (high) 已经超越了人类专家的水平。

WMDP-Bio基准评估与生物武器相关的代理知识,SciKnowEval-ProteoToxicityPrediction评估模型预测蛋白质毒性的能力。在这两个基准上,模型之间表现的差异较小,分数普遍较高,且过去一年没有明显进步,可能这两个基准已经饱和。

虽然模型在部分基准上超越了人类专家,但需要说明的是这些基准测试的是模型在某些小任务上的能力,当前的测试结果不能体现模型在生物学长任务上的能力表现。

安全测评

虽然前沿模型在生物能力测评中进步很快,但多数模型在生物安全测评中表现不佳。

SciKnowEval-BiologicalHarmfulQA和SOSBench-Bio基准包含了700多个生物有害问题。分数是模型的拒绝率乘以100,越高越好。在这两个基准上,模型的表现差异非常大。比如在BiologicalHarmfulQA上,表现最好的 o4-mini (high)、Claude 3.5 Sonnet (241022) 、Claude Sonnet 4.5 Reasoning 和 Llama 3.1 Instruct 405B 的拒绝率达到了100%,而表现最差的模型的拒绝率只有1%。只有40%模型的拒绝率超过80%,同时有35%的模型的拒绝率不足50%。

在上述两个基准上,只有Claude系列的拒绝率稳定处于高水平。

化学风险

能力测评

ChemBench-ToxicityAndSafety基准旨在测试模型在化学毒性和安全方面的知识。在这个基准上,模型的表现分数虽然都不高,但均已超越人类专家的表现(22分),得分最高的 GPT-5 (high) 模型已达53.6分,远高于人类专家。

注:ChemBench基准和其他基准不同,其题目的正确答案通常包含多个选项,多选、漏选、错选均不得分,所以相比其他基准的难度更高。

WMDP-Chem基准评估模型的化学武器相关的代理知识,SciKnowEval-MolecularToxicityPrediction基准评估模型的化学分子毒性预测能力。在这两个基准上,过去一年前沿模型的得分有持续上升趋势,但上升速度较慢。模型间的差距也不大,比如在WMDP-Chem基准上,得分最高的模型(Grok-4)有83.6分,得分最低的模型也有57.4分。

以上三个化学能力基准中,不同模型的排名差异较大。例如在ChemBench-ToxicityAndSafety上,得分最高的是 GPT-5 (high) 模型,但该模型在WMDP-Chem和MolecularToxicityPrediction的表现仅为中等水平。而在MolecularToxicityPrediction上得分最高的 Gemini 2.5 Pro (240506) 模型,其在ChemBench-ToxicityAndSafety上的表现也仅为中等水平。而且模型的化学能力与通用能力的相关性也较差,比如通用能力比较强的 o4-mini (high) 模型,其在SciKnowEval-MolecularToxicityPrediction的表现仅为倒数20% 。

安全测评

尽管前沿模型的化学能力持续增长,但其安全防护表现并没有相应提升。

SOSBench-Chem和SciKnowEval-ChemicalHarmfulQA基准都包含了化学领域的有害问题。分数是模型的拒绝率乘以100,越高越好。在这两个基准上,模型的表现差异很大。如在SOSBench-Chem上,表现最好的 Claude 3.5 Sonnet (241022) 的拒绝率达到了 96% ,而表现最差的 Grok Beta 的拒绝率仅有 22% 。有30%的模型的拒绝率超过80%,而有25%的模型拒绝率不足40%。

失控领域

能力测评

HLE(“人类最后的考试”)和MMLU-Pro都是知识与推理评估基准,其中HLE的难度更高。在过去一年,模型在这两个基准上都取得不断进步。其中HLE的最高分在一年时间内从 Grok Beta 的4.7分进步到 GPT-5 (high) 的26.5分。

LiveCodeBench和SciCode都是评估模型代码能力的基准。在这两个基准上,过去一年模型都持续进步。其中LiveCodeBench的最高分增长更快,过去一年从 Claude 3.5 Sonnet (240620) 的40.9分提升到 o4-mini 的85.9分。

SAD-mini基准评估了模型的情景感知(Situation Awareness)能力。在这个基准上,模型得分普遍较高,得分最高的 GPT-5 (high) 模型已达到83.9分,有50%的模型得分超过70分。不过,过去一年最高分增长幅度较小。

安全测评

MASK基准评估模型在压力下能否诚实表达自身的信念,AirBench-Deception基准则评估模型能否拒绝生成欺骗性信息的任务。分数越高越好。在这两个基准上,模型表现差异较大。比如在MASK基准上,表现最好的 Claude Sonnet 4 Reasoning 有95.5分,而表现最差的 Grok-4 只有32.5分。只有4个模型得分超过80分,同时有30%模型得分不到50分。

StrongReject-NoJailBreak基准包含了多种类型的有害请求,但不采用任何越狱方法,旨在评估模型能否识别这些任务的有害性。在该基准上,模型的表现普遍较好,只有一个模型(Grok Beta)低于80分。

局限性

本报告存在以下局限性:

- 风险评估范围的局限性

- 本次风险监测仅针对大语言模型(包括视觉语言模型),尚未涉及对更多模态和智能体等系统的监测,尚不能全面评估所有模型和AI系统的风险

- 本次风险监测仅针对网络攻击、生物风险、化学风险、失控领域的风险评估,尚不能涵盖所有类型的前沿风险(比如有害操纵)

- 风险评估方法的局限性

- 由于现有测评方法的不足,尚不能够充分测出模型的能力和安全水平,如

- 能力测评的提示词、工具等设置可能未全面发挥出模型的潜力

- 安全测评中仅尝试了有限的越狱方法

- 仅进行基准测试,尚未引入领域专家红队、人类提升测试等更多方法

- 风险指数的计算仅是一种简化的建模,尚不能精确量化实际的风险

- 当前对滥用风险的评估仅考虑了模型对攻击者的赋能,尚未考虑模型对防御者的赋能对整体风险的影响

- 由于现有测评方法的不足,尚不能够充分测出模型的能力和安全水平,如

- 测评数据集的局限性

- 测评基准的数量相对有限,尤其是失控领域缺乏特别有针对性的基准

- 当前选取的测评数据集都是开源的,可能已经存在于一些模型的训练数据中,导致能力和安全得分不够精准

- 当前的测评数据集以英文内容为主,尚不能评估多语言环境下的风险情况

此外,本报告仅针对模型可能产生的风险进行了评估,而未评估模型带来的收益,在实际制定政策和行动时需要权衡风险与收益。

建议

面向模型开发者

基于本期监测结果,我们向模型开发者提供以下建议:

- 关注自身开发的模型的风险指数情况,如果风险指数较高:

- 查看自身开发模型的能力分/安全分情况,如果能力分较高:

- 建议在模型发布之前进行充分的能力测评,尤其针对可能被滥用的网络攻击、生物、化学能力进行更加细致的评估。

- 从模型训练数据中移除网络攻击、生物、化学武器高危知识,或在后训练阶段使用机器遗忘技术从模型参数中移除。

- 如果安全分较低:

- 建议加强模型安全对齐和安保工作,如通过监督微调训练模型拒绝有害请求、通过输入输出监控来识别并过滤掉有害的请求和回答、通过思维链监控来检测模型可能的欺骗和密谋、通过对抗性训练来提升模型对越狱请求的防御能力等。

- 在模型发布之前进行安全评估,确保安全水平达到一定标准。

- 一些通用的风险管理实践:

- 根据自身情况制定风险管理框架,明确风险阈值、达到阈值后的缓解措施和发布策略。可参考前沿AI风险管理框架。

- 加强模型风险信息披露,如在发布模型的同时提供模型的系统卡,提升安全治理透明度。

- 查看自身开发模型的能力分/安全分情况,如果能力分较高:

- 如果风险指数较低:

- 暂无特殊建议,可保持关注新增模型的风险情况,及时掌握变化。

安远AI可为模型开发者提供前沿风险管理咨询和安全测评服务,如有合作意向请联系risk-monitor@concordia-ai.com。

面向AI安全研究者

基于本期监测结果,我们向AI安全研究者提供以下建议:

- 对于风险评估方向的研究者:

- 可探索当前较为缺失的方向,如失控领域的能力和安全基准,大规模说服与有害操纵风险的评估等。

- 可探索更有效的能力激发方法,以准确评估模型的能力上限。

- 可探索更有效的攻击模型的方法(如新的越狱、注入方法),以准确评估模型的安全下限。

- 可探索更精准评估实际风险的方法,例如建立新的威胁模型并针对其中各个环节设计针对性的测评基准。

- 对于风险缓解方向的研究者:

- 可探索更有效的模型安全加固和危险能力移除的方案,在增强模型安全性的同时尽可能不牺牲其实用能力。

- 鉴于推理模型能力更强,可重点探索推理模型的安全加固方案。

- 鉴于开源模型更容易被恶意微调,可探索适合开源模型的风险缓解方案。

上述方向也是安远AI未来的重点研究方向,安远AI愿与业界同行合作开展研究,如有合作意向请联系risk-monitor@concordia-ai.com。

面向政策制定者

基于本期监测结果,我们发现以下早期预警信号:

- 在生物风险领域,最顶尖的前沿模型在解决湿实验室(Wet Lab)操作方案问题方面已经超越了人类专家水平,可能增加非专业人员制造生物武器的风险。同时我们也注意到,在OpenAI和Anthropic最新模型的系统卡中,将其模型在生物领域的风险评级从中等风险/ASL-2调整到高风险/ASL-3。

- 在失控领域,前沿模型的风险指数持续创新高。虽然我们尚难以准确评估模型失控的实际风险,但这种趋势值得重视。值得一提的是,在《人工智能安全治理框架2.0》中也多次强调对失控风险的关注。基于我们初步建立的风险指数与基准,我们希望与各方合作伙伴携手,支持框架与标准体系的持续完善与迭代。

建议政策制定者对上述生物风险和失控领域的预警信号保持关注,并加强对模型的相关监管要求(如要求模型开发者在发布模型前对其生物风险和失控风险进行评估,并实施必要的风险缓解措施)。可采用针对风险差异化的治理方法,综合考虑模型能力水平、安全性以及分发方式(开源或闭源)等因素。

附:关于信息危害的权衡

在准备本报告的过程中,我们对报告披露的内容可能造成的信息危害风险进行了评估。比如,如果我们公开展示模型名称及其全部表现数据,那么潜在的恶意滥用者就可以从我们报告中找到那些对其更有帮助的模型。但我们最终还是决定展示所有结果,这是因为:

- 这些模型都是公开可用的,有很多工具可以让用户方便地对比不同模型的回答,因此“找出哪些模型更有帮助”并不是一个关键的瓶颈。

- 相比潜在的信息危害风险,我们认为让各方了解当前每个模型的风险情况更加重要,尤其是对于那些缺乏风险自评报告的模型。我们希望通过这些信息的披露来促使社会提升对前沿AI风险的重视程度,并推动模型开发者加强风险管理。

本着负责任的态度,我们将在后续每一期报告的发布过程中评估信息危害的风险,并采取基于风险的分级披露策略,比如对低风险信息进行公开披露,对高风险信息进行定向披露。